快訊

- 中國台辦痛批美國「武裝台灣」 美國務院重申對台承諾不變

- 張文北捷殺3人後墜樓亡!父母崩潰首度發聲 自導自演酒駕遭軍汰除

- 喊停火和談只是虛晃一招?美情報:普丁欲奪下整個烏克蘭

- 見人就叫歐爸、歐膩 「韓式稱謂」學問大!竟讓青瓦台官員丟飯碗?

- 致命1刀刺穿心肺!57歲保全肉身擋刀彈送命 妻淚:他平時就富正義感

- 【吃電怪獸3-3】引導AI資料中心提高能效、落腳中南部 學者建議台電訂差別費率

- 美司法部公開富豪淫魔檔案 大量柯林頓照片曝光、少見川普

- 一文懂台灣捷運隨機殺人3憾事 鄭捷、洪淨、張文奪8命!一共通點毛骨悚然

- 【吃電怪獸3-1】AI答題用電量驚人!2機櫃輝達GB300電力負載就超過整棟台電大樓

- 報復兩名美軍遇襲喪生 美率聯軍空襲敘利亞數十個「伊斯蘭國」據點

- 幕後/黃國昌的新考驗!高虹安滿血回鍋新竹市長 黨內估新勢力漸成形

- 北捷恐攻4死「人群奔逃如末日」 張文犯前4度縱火時間軸!這原因警抓人撲空

- 【專訪】教棒球、課輔供吃住…練習曲書店深耕花蓮10年「人留下才有希望」

- 張文台北隨機傷人案國際關注 外媒形容「車站驚魂」

- 守護孩子到6歲!兒童專責醫師拚明年上路?衛福部:卡在這關鍵

- 修《憲訴法》搞「國會至上」! 大法官尤伯祥「萬言書」:不能坐視立法院擴權

- 外媒報北捷4死案「暴力犯罪在台罕見」 《衛報》追煙霧彈來源

- 7名大法官吵架就「她」沉默!今終於表態:積案再不處理將如「堰塞湖溢流」

- 影/縱火燒屋調虎離山...再北車丟彈!張文預謀犯案搜出25顆汽油彈

- 【更新】疑幫鍾文智簽到助其潛逃 副所長李俊良不明金流逾千萬裁准羈押禁見

【吃電怪獸3-1】AI答題用電量驚人!2機櫃輝達GB300電力負載就超過整棟台電大樓

2025-12-20 07:50 / 作者 吳馥馨

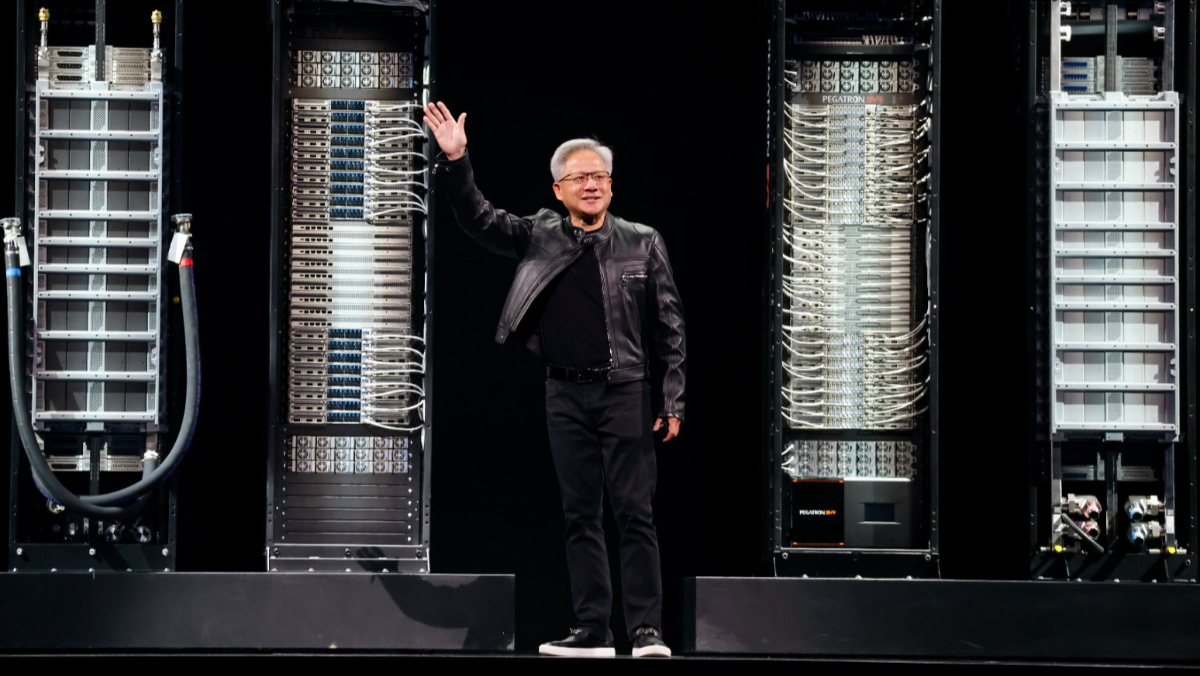

台電董事長曾文生說,輝達GB300只要2個機櫃,用電量就超過整棟台電大樓,高用電密度也給電力韌性帶來挑戰。圖為輝達執行長黃仁勳,李政龍攝

ChatGPT橫空出世後,「凡事問AI」已成眾人日常;而你是否曾經好奇,人們每問Google一個問題,每問ChatGPT一個問題,要用多少電? 日前台電公司高層舉行一場內部研討會,廣邀學者專家探討AI Data Center時代下電網韌性的挑戰與因應;中正大學電機系教授張文恭就在會中拋出以上靈魂考問。

張文恭說,以上這些疑問,在他查閱國際能源總署(IEA)刊物後得到解答;每問Google一個問題,用電量是0.3瓦特小時;若是問Chat GPT則是2.9瓦特小時,也就是說,ChatGPT用電量大概是Google的10倍。

張文恭再比喻,如果將一杯約250毫升約20℃常溫水燒開,所需要的電力大約就是向ChatGPT提問100次到150次。

而這些電力都消耗在哪個環節?張文恭經過思索後恍然大悟,原來都是AI Data Center(AI資料中心)裡的伺服器在用電。

台電董事長曾文生則具像化說明,以輝達GB300伺服器為例,1個機櫃的電力負載就1.4MW,2個機櫃就高達2.8MW,用電量遠遠高於整棟台電大樓的2.5MW。

台電總經理王耀庭也說,1個機櫃大小約2公尺高,19吋見方,相當於一個冰箱的大小,很難想像一個小房間塞滿算力機櫃的用電量。此外,為了傳輸這些算力機櫃所需電力,這樣等級的電纜是一條手臂粗的電線將三條一組纏繞一起,恐怕需要幾十條;王耀庭反問,若要布建這些電纜,台北市的地底下可以這樣無限制的開挖嗎?

王耀庭最後自我解嘲,所幸現在2個機櫃的GB300就要價1億元,成本考量之下,初期裝設量還不至太多太快。但他也預料,待未來AI應用更廣泛後,AI資料中心的設置量將呈指數型成長,這意味著將來電力需求也是指數型成長。

也就是說,若都會區極小的商辦空間設置AI算力中心,局部電網用電量將遠遠高過工廠林立的工業區,用電密度極大,對局部電網帶來非常高的挑戰。

因此,如何在發展AI的同時,又能兼顧電力供應與韌性,如何與AI資料中心這群「吃電怪獸」和平相處,成為台電公司當下最大挑戰。

最新more>

- 中國台辦痛批美國「武裝台灣」 美國務院重申對台承諾不變

- 張文北捷殺3人後墜樓亡!父母崩潰首度發聲 自導自演酒駕遭軍汰除

- 張文中山站第一刀 騎士停等紅燈竟被割喉!倒地瞬間影片曝

- 喊停火和談只是虛晃一招?美情報:普丁欲奪下整個烏克蘭

- 遇煙霧彈攻擊怎麼辦?醫授6招自保:濕布遮口鼻、避免揉眼睛

- 見人就叫歐爸、歐膩 「韓式稱謂」學問大!竟讓青瓦台官員丟飯碗?

- 致命1刀刺穿心肺!57歲保全肉身擋刀彈送命 妻淚:他平時就富正義感

- 【吃電怪獸3-3】引導AI資料中心提高能效、落腳中南部 學者建議台電訂差別費率

- 美司法部公開富豪淫魔檔案 大量柯林頓照片曝光、少見川普

- 【吃電怪獸3-2】我們回不去了!學者獻策因應台灣國情「算力」必須追隨「電力」

熱門more>

- 護理師變酒店「當紅頭牌」 清純制服照曝!首談醫科大學畢業下海原因

- 北車、北捷無差別殺人!黑衣男行兇後墜樓亡 起底「27歲、逃兵通緝」

- 4死9傷!台北車站「丟煙霧彈」再逃中山站隨機砍人 27歲逃兵墜地亡

- 「彈劾賴清德」網站連署破200萬 她抓包一疑點:不可思議

- 【一文看懂】美軍可能進攻委內瑞拉的「無敵艦隊」兵力

- 大法官出手救國!宣告《憲法訴訟法》修法違憲 癱瘓1年憲法法庭復活

- 女嗑藥配酒四肢扭曲 男友「邊拍影片邊笑」!延誤送醫不治

- 震撼彈!憲法法庭癱瘓1年大復活 8名大法官今針對《憲法訴訟法》產出「新判決」

- 獨家/超荒謬!剴剴案再爆兒盟涉「串證」 2主管出庭前先找陳尚潔「委任律師」

- 雪地中感人一幕!北極熊「收養」陌生幼熊 科學家動容